相比起之前的方法,我们做出的主要改变是不单单利用word embeddings,还把knowledge graph的信息通过graph convolution network利用起来。 我们相信这是zero shot learning之后发展的方向。 Zero-shot-cot 零样本思维链(zero shot chain of thought,zero-shot-cot)提示过程是对 cot prompting 的后续研究,引入了一种非常简单的零样本提示。 他们发现,通过在问题的结尾附加“ lets think step by step ”这几个词,大语言模型能够生成一个回答问题的思维链。 Standard zero-shot learning: 第一次定义了domain shift问题。 (4)zero-shot recognition using dual visualsemantic mapping paths [11] 解决semantic gap问题的简单做法。 (5)predicting visual exemplars of unseen classes for zero-shot learning [12] 从本质的角度出发,将zsl问题,看作聚类问题,用最简单的方法直接建立映射。 Test on only unseen classes. · 我个人常用 maru,zero用得偏少,很少说「れい」,在语音流中「れい」显得极不自然,感觉很容易跟前后单词混淆在一起,可能跟「r」这个舌尖闪音发音不方便或者发音偏向元音有关,就如同我们单说数字1的时候,经常会说「yao」而不是「yi」。 Generalized zero-shot learning: Test on seen and unseen classes.

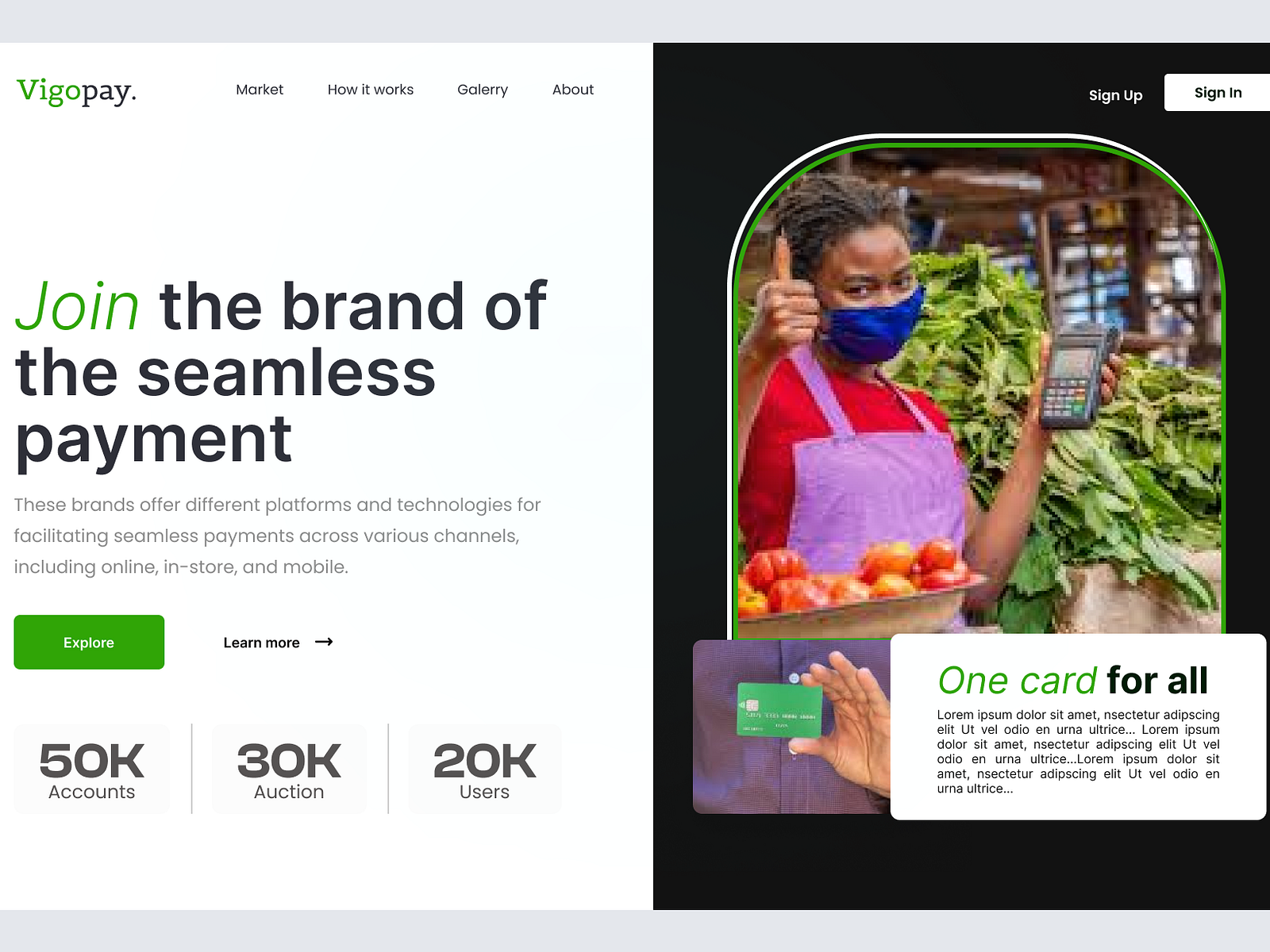

From Zero To Fintech Hero Subhashree Sahus Fsi Blogs Ultimate Guide

相比起之前的方法,我们做出的主要改变是不单单利用word embeddings,还把knowledge graph的信息通过graph convolution network利用起来。 我们相信这是zero shot learning之后发展的方向。 Zero-shot-cot 零样本思维链(zero shot chain of thought,zero-shot-cot)提示过程是对 cot prompting 的后续研究,引入了一种非常简单的零样本提示。 他们发现,通过在问题的结尾附加“ lets think step by step ”这几个词,大语言模型能够生成一个回答问题的思维链。 Standard...